Meta xuất bản mã trong trí tuệ nhân tạo truy cập mở dưới tên liên kết hình ảnh, dự đoán mối quan hệ giữa dữ liệu tương tự như cách mọi người nhận thức hoặc tưởng tượng về môi trường của họ. Trong khi các trình tạo hình ảnh như Midjourney, Stable Diffusion và DALL-E 2 liên kết các từ với hình ảnh, cho phép bạn tạo các cảnh trực quan chỉ dựa trên mô tả văn bản, thì ImageBind còn vượt xa điều đó. Nó có thể liên kết văn bản, hình ảnh hoặc video, âm thanh, phép đo 3D, dữ liệu nhiệt độ và dữ liệu chuyển động – và làm như vậy mà không cần đào tạo trước ở mọi cơ hội. Đây là giai đoạn đầu của một khung mà cuối cùng sẽ có thể tạo ra các môi trường phức tạp từ các đầu vào đơn giản như lời nhắc văn bản, hình ảnh hoặc âm thanh (hoặc sự kết hợp của chúng).

Bạn có thể nghĩ về ImageBind như một sự gần đúng giữa học máy với học của con người. Ví dụ: nếu bạn đang đứng trong một môi trường năng động, chẳng hạn như đường phố đông đúc, bộ não của bạn (hầu hết là vô thức) hấp thụ hình ảnh, âm thanh và các cảm giác giác quan khác để nhận thông tin về ô tô chạy qua, tòa nhà cao tầng, thời tiết, v.v. . Con người và các loài động vật khác đã tiến hóa để xử lý dữ liệu này vì lợi ích di truyền của chúng ta: sự sống sót và truyền lại DNA của chúng ta. (Bạn càng biết nhiều về môi trường xung quanh, bạn càng có thể tránh được nguy hiểm và thích nghi với môi trường của mình để tồn tại và phát triển tốt hơn). Khi máy tính tiến gần hơn đến việc bắt chước các kết nối đa giác quan của động vật, chúng có thể sử dụng các kết nối đó để tạo ra các cảnh hoàn chỉnh chỉ dựa trên các mẩu dữ liệu hạn chế.

Vì vậy, mặc dù bạn có thể sử dụng Midjourney để tạo “một chú chó săn basset trong trang phục Gandalf đang giữ thăng bằng trên một quả bóng bãi biển” và có được một bức ảnh tương đối chân thực về khung cảnh kỳ lạ đó, nhưng một công cụ AI đa phương thức như ImageBind có thể sẽ tạo ra một video về chú chó với nội dung phù hợp. âm thanh, bao gồm phòng khách chi tiết, nhiệt độ phòng và vị trí chính xác của con chó và mọi người khác trong cảnh. "Điều này tạo ra một cơ hội tuyệt vời để tạo hoạt ảnh từ hình ảnh tĩnh bằng cách kết hợp chúng với lời nhắc âm thanh", các nhà nghiên cứu Meta lưu ý trong blog hướng đến nhà phát triển của họ. "Ví dụ: người sáng tạo có thể kết hợp hình ảnh với đồng hồ báo thức và tiếng gà trống gáy, đồng thời sử dụng tín hiệu âm thanh để phân đoạn tiếng gà trống hoặc âm thanh của đồng hồ báo thức để phân đoạn đồng hồ và tạo hoạt ảnh cho cả hai trong một chuỗi video."

Đối với những gì khác có thể được thực hiện với đồ chơi mới này, rõ ràng nó chỉ ra một trong những tham vọng cốt lõi của Meta: VR, thực tế hỗn hợp và siêu không gian. Ví dụ: hãy tưởng tượng một chiếc tai nghe trong tương lai có thể dựng các cảnh 3D hoàn chỉnh (với âm thanh, chuyển động, v.v.) một cách nhanh chóng. Hoặc các nhà phát triển trò chơi ảo cuối cùng có thể sử dụng nó để tiết kiệm cho mình một phần quan trọng trong công việc khó khăn trong quá trình thiết kế. Tương tự như vậy, người tạo nội dung có thể tạo các video sống động với các bản nhạc và chuyển động chân thực chỉ dựa trên văn bản, hình ảnh hoặc âm thanh. Cũng dễ hình dung cách một công cụ như ImageBind mở ra những cánh cửa mới về khả năng truy cập bằng cách tạo các mô tả đa phương tiện theo thời gian thực để giúp những người khiếm thị hoặc khiếm thính hiểu rõ hơn về môi trường của họ.

Cũng thú vị: Các công cụ tốt nhất dựa trên trí tuệ nhân tạo

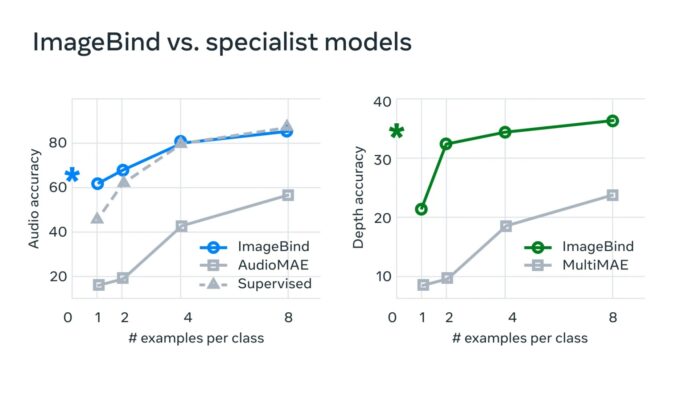

Meta cho biết: “Trong các hệ thống AI điển hình, có một cách nhúng cụ thể (tức là các vectơ số có thể biểu thị dữ liệu và mối quan hệ của chúng trong máy học) cho từng phương thức liên quan. “ImageBind cho thấy rằng có thể tạo một không gian nhúng chung cho nhiều phương thức mà không cần phải huấn luyện dữ liệu với từng tổ hợp phương thức riêng lẻ. Điều này rất quan trọng vì các nhà nghiên cứu không thể tạo bộ dữ liệu với các mẫu chứa, chẳng hạn như dữ liệu âm thanh và dữ liệu nhiệt từ một con phố đông đúc trong thành phố hoặc dữ liệu độ sâu và mô tả bằng văn bản về một vách đá bên bờ biển.”

Meta tin rằng công nghệ này cuối cùng sẽ vượt xa sáu "giác quan" hiện tại, có thể nói như vậy. "Mặc dù chúng tôi đã điều tra sáu phương thức trong nghiên cứu hiện tại của mình, nhưng chúng tôi tin rằng việc giới thiệu các phương thức mới kết nối càng nhiều giác quan càng tốt - chẳng hạn như xúc giác, lời nói, khứu giác và tín hiệu não fMRI - sẽ cho phép các mô hình AI lấy con người làm trung tâm phong phú hơn." Các nhà phát triển quan tâm đến việc khám phá hộp cát mới này có thể bắt đầu bằng cách đi sâu vào mã nguồn mở của Meta.

Đọc thêm: